PROTOCOLO, CONTROLE E REDES

ALEXANDER GALLOWAY & EUGENE THACKER

Originalmente publicado em: Grey Room 2004, Vol. 17, Fall, 6-29

Tradução: Ednei de Genaro

* * *

Na última década ou mais, discussões sobre as redes têm proliferado de uma forma intensamente epidêmica: redes de compartilhamento de arquivos ponto a ponto, comunidades em redes sem fio, redes terroristas, redes de contágio por agentes de guerra biológica, enxameamento e manifestações em massas, redes econômicas e financeiras, jogos de RPG [Role-Playing Games] para quantidade massiva de jogadores, ambientes de redes pessoais, computação em grade, “geração txt”, e assim por diante. Frequentemente, os discursos sobre as redes tendem a ser dispostos, arquitetural e moralmente, contra o que seus integrantes veem como estruturas retrógadas de hierarquia e verticalidade, pelas quais dispõem suas coexistentes estruturas a fim de manter as coisas sob controle: burocracia, cadeias de comando, e assim por diante. “Estamos cansados da árvore”, escreveram Deleuze e Guattari. Não obstante, o conceito de redes não se limitou aos campos da tecnologia e da filosofia, tendo infestado vastas áreas da vida contemporânea. Até mesmo as Forças Armadas dos Estados Unidos, bastião da verticalidade, de hierarquia piramidal, vem redefinindo sua estrutura interna por meio de arquiteturas em redes, como vem apontando os pesquisadores da RAND Corporation John Arquilla e David Ronfeldt. O conceito de “netwar” desses pesquisadores é definido em termos topológicos: “Hierarquias expõem problemas às redes. […] É preciso redes para lutar contra redes. […] Quem primeiro e melhor dominar as redes terá as maiores vantagens”[1]. Em resumo, a atual crise global é uma crise assimétrica entre poderes centralizados ou hierárquicos e redes distribuídas ou horizontais[2]. Hoje, a sabedoria convencional nos leva a pensar que tudo pode ser subsumido sob o manto da segurança da interconectividade. Contudo, ainda não nos foi dito o que isso significa, ou como se poderia elaborar uma crítica das redes. Tal “febre das redes”[3] tem uma tendência delirante, pois se percebe na atual literatura uma vontade geral de ignorar a política, mascarando-a na dita chamada caixa-preta da tecnologia. O que é necessário, pois, é uma análise das redes, não pelo plano geral da teoria política, mas por via do nível microtécnico do não-humano, das práticas maquínicas. Para tal finalidade, sugerimos que o princípio de controle político mais útil para lidar com redes tecnológicas é o protocolo, uma palavra derivada da ciência da computação, mas que ressoa também nas ciências da vida. Ações em uma rede podem ser deliberadamente orientadas por humanos ou acidentalmente afetadas por atores não-humanos (um vírus de computador ou uma doença infecciosa em evolução, por exemplo). Frequentemente, o mau uso ou o exploit de um protocolo, seja intencional ou não, pode salientar as fissuras políticas em uma rede. Sugerimos que em tais momentos, ainda que muitas vezes politicamente ambíguos quando tirado dos contextos, podem servir também de interesse para a prática de “contraprotocolo” mais crítica e engajada. Como veremos, o controle protocológico trás à tona certa contradição, ao mesmo tempo distribuindo agenciamentos de maneira complexa e concentrando formas rígidas de gerenciamento e controle.

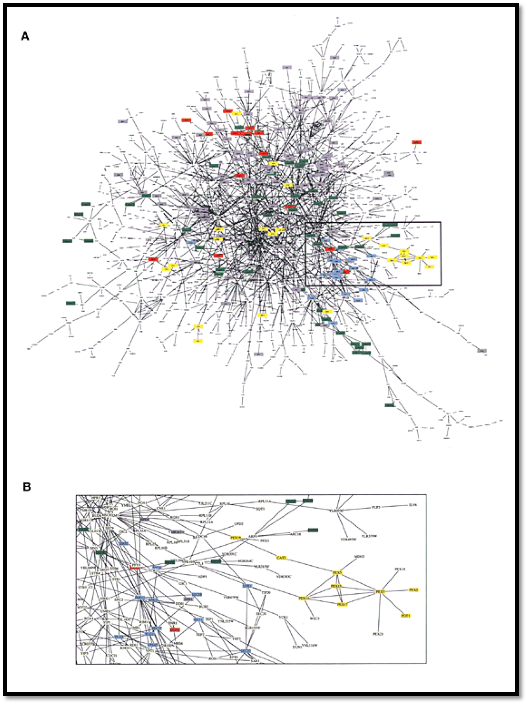

Figura 1: Bureau d’Etudes. Psy-war Bio-war, 2003. Detalhe. Disponível em: http://utangente.free.fr/2003/PSYWAR.pdf

A Política da Cultura Algorítmica

A questão que centralmente exploraremos aqui é: qual é o princípio da organização ou controle político que entrelaça uma rede? Escritores como Michael Hardt e Antonio Negri têm ajudado a responder essa questão na esfera sociopolítica. Eles descrevem o princípio global de organização política com um “Império”. Tal como as redes, o Império não é reduzido a qualquer poder estatal, nem mesmo segue uma arquitetura de hierarquia piramidal. Império é fluido, flexível, dinâmico e de longo alcance. Assim, o conceito de Império nos ajuda largamente a começar a pensar sobre a organização política das redes. Contudo, embora inspirados pelas contribuições da filosofia política de Hardt e Negri, o nosso enfoque recai onde ainda ninguém respondeu adequadamente a questão, na esfera tecnológica, dos bits e átomos.

Pois bem. O que é “protocolo”? Protocolo é abundante na tecnocultura. É um dispositivo de controle totalizante que direciona as formações técnica e política das redes de computadores, dos sistemas biológicos, e de outras mídias. De forma simples, protocolos são todas regras convencionais e padrões que governam as relações por meio de redes. Recorrentemente, tais relações aparecem na forma de comunicação entre dois ou mais computadores; contudo, “relações em redes” podem também se referir puramente a processos biológicos, como no fenômeno sistêmico de expressão genética. Assim, por “redes” queremos nos referir a qualquer sistema de inter-relação, biológica ou informática, orgânica ou inorgânica, técnica ou natural, com a finalidade última de desfazer a restritividade polar entre esses pares.

Em redes de computadores, cientistas têm, por anos, elaborado centenas de protocolos para regular e-mail, páginas da Web etc., além de muitos outros padrões tecnológicos raramente vistos pelos olhos humanos. O primeiro protocolo para redes de computadores foi escrito em 1960 por Steve Crocker e o nome era “Host Software” [Software Hospedeiro][4]. Se as redes são estruturas que conectam pessoas, então os protocolos são as regras que fazem as redes funcionarem efetivamente. Os usuários da Internet geralmente usam protocolos como HTTP, FTP e TCP/IP, mesmo não sabendo nada sobre como tais padrões funcionam. Da mesma maneira, a pesquisa em biotecnologia molecular frequentemente faz uso de protocolo para configurar a vida biológica como um fenômeno de rede, seja isto em redes de expressão gênica, redes metabólicas ou em circuitos de sinalização celular. Em tais instâncias, o biológico e o informático tornam-se progressivamente enredados em sistemas híbridos que são mais que biológicos: banco de dados genômicos, chips de DNA para diagnósticos médios e sistemas de detecção em tempo real de agentes de guerra biológica. Protocolo é duplo; é tanto um aparato que viabiliza as redes como uma lógica que governa como as coisas são efetivadas com tais aparatos. Ainda que seu modelo elementar seja a rede informática (por exemplo, a Internet), iremos mostrar aqui como o protocolo também ajuda a organizar as redes biológicas (por exemplo, as biovias).

Um recente manual de ciência da computação descreve a implantação de um protocolo na Internet:

A rede é feita de sistema terminais inteligentes que são autodeterminísticos, permitindo que o sistema terminal se comunique com qualquer host que escolher. Em vez de ser uma rede na qual as comunicações são controladas por uma autoridade central (identificada em muitas redes privadas), a Internet é especificamente concebida para ser uma coleção de hosts autônomos que podem se comunicar livremente entre eles… O IP [Internet Protocol] usa um modelo anárquico e altamente distribuído, com cada dispositivo sendo um par idêntico a qualquer outro dispositivo em toda Internet[5].

Que tal passagem pareça mais uma filosofia que uma ciência é particularmente reveladora. Hoje a ciência das redes muitas vezes evoca os temas da anarquia, do rizomático, do distribuído e da antiautoridade para explicar os sistemas interconectados de todos os tipos. Por meio destes prognósticos às vezes radicais, e do largo discurso tecnológico de milhares de white papers, memorandos e manuais, podemos derivar algumas qualidades básicas dos aparatos de organização que denominamos protocolo:

- O protocolo viabiliza relações de entidades interconectadas, contudo autônomas;

- As virtudes do protocolo incluem robustez, contingência, interoperabilidade, flexibilidade e heterogeneidade;

- Uma finalidade do protocolo é acomodar tudo, não importando qual a origem ou destino, definição ou identidade originária;

- Embora o protocolo seja universal, ele sempre é auferido por meio da negociação (significando que o protocolo futuro pode e será diferente);

- O protocolo é um sistema para manter organização e controle em rede.

Cada uma dessas características por si só é suficiente para destacar o protocolo de muitos outros modos sociais e técnicos de organização (tal como a hierarquia ou a burocracia). Unidos, eles compõem um novo e sofisticado sistema distribuído de controle. Enquanto uma tecnologia, o protocolo é implantado extensamente, não sendo, portanto, reduzido simplesmente ao âmbito do poder institucional, governamental ou corporativo. No sentido mais geral, o protocolo é uma tecnologia que regula os fluxos, direciona os espaços em rede, codifica as relações e conecta as formas de vida.

As redes sempre têm variados protocolos operando no mesmo espaço e tempo. As redes são sempre meio esquizofrênicas, realizando uma coisa aqui e outra contrária lá. Assim, o conceito de protocolo não descreve uma rede abrangente de poder – não existe apenas uma Internet, mas muitas, todas comportando uma relação específica com a história da infraestrutura das indústrias militar, de telecomunicação e científica. O protocolo tem, pois, menos a ver com os sujeitos humanos individualmente empoderados (o mito da cultura pop sobre o hacker), que podem ser os motores de uma visão teleológica para o protocolo, e mais a ver com os múltiplos modos de individuação que organizam e misturam os elementos humanos e não-humanos. Mas a inclusão da oposição por dentro do tecido do protocolo não é simplesmente devido ao pluralismo. O controle protocológico desafia-nos a repensar as ações crítica e política a partir de uma nova estrutura, múltipla agenciada e individuada, em rede metaestável. Isso significa que o protocolo é menos a respeito do poder (confinamento, disciplina, normatividade) e mais sobre o controle (modulado, distribuído, flexível).

Teoria dos Grafos na Sociedade de Controle

A ênfase no “controle” é uma parte significativa dos últimos escritos de Deleuze. No Post-Scriptum sobre as sociedades de controle, um deleitoso pequeno ensaio de 1990, Deleuze define duas formações históricas distintas: primeiro, as “sociedades disciplinares” da modernidade, ascendidas pelo domínio do soberano a um “vasto espaço de clausura”, de personas e moldes sociais, descritos tão bem por Michel Foucault; segundo, o que Deleuze descreve em termos de “sociedades de controle” que habitam desde o final do século XX – essas baseadas em protocolos, lógicas de “modulação”, e em “formas ultrarrápidas de controle flutuante” [6]. Enquanto as sociedades disciplinares são mais caracterizadas por construções semióticas físicas, como a assinatura de documentos, as sociedades de controle são, por sua vez, mais caracterizadas por construções imateriais, tais como a senha e o computador. Sociedades de controles são definidas pelas redes de ciência genética e de computadores, contudo também por meio de formas de redes bem convencionais:

Um controle não é uma disciplina. Ao fazer autoestradas, por exemplo, não se enclausura as pessoas, mas, em vez disso, multiplicam-se os meios de controle. Eu não digo que isso seja o propósito único das autoestradas, mas que as pessoas podem trafegar infinita e “livremente” sem serem confinadas, ainda que sendo elas perfeitamente controladas. Esse é o futuro[7].

Seja isso um roteiro político, um itinerário patológico, uma autoestrada da informação ou simplesmente uma estrada, o que Deleuze define como controle é a chave para compreender como as redes de todos os tipos funcionam.

No entanto, existe também toda uma ciência por trás das redes, comumente conhecido como teoria dos grafos, que gostaríamos de introduzir aqui[8]. Matematicamente falando, um “grafo” é um conjunto finito de pontos conectados por um conjunto finito de linhas. Os pontos são chamados de “nós” ou vértices, e as linhas são chamadas de “arestas”. Por conveniência vamos usar “G” para se referir a um grafo, “N” para se referir aos nós no grafo e “E” para se referir às suas arestas. Assim, um simples grafo com quatro nós (ou seja, um quadrado) pode ser representado como:

N = {n1, n2, n3, n4}

E suas arestas como:

E = {(n1, n2), (n2, n3), (n3, n4), (n4, n1)}

Em um grafo, o número de nós é chamado de “ordem” (no exemplo do quadrado, |N|=4) e o número de arestas é chamado de “tamanho”(|E| = 4). Essa é a situação padrão de conectar-os-pontos. Conhecendo tal configuração básica de nós e arestas, um número de relações pode ser quantitativamente analisado. Por exemplo, o “grau” de um nós é o número de arestas conectadas a ele. Um grafo “centralizado” ou “descentralizado” existe quando um ou vários nós no grafo têm muitas arestas conectadas a ele (expressando isso uma ordem menor e um tamanho maior). Do mesmo modo, um grafo “distribuído” existe quando todos nós no grafo têm aproximadamente o mesmo grau (expressando isso relação de ordem-tamanho bastante aproximada [ordem = tamanho]).

O que diríamos sobre a ordem e o tamanho de um grafo? Um teorema básico de uma teoria dos grafos postula que para qualquer grafo G, a soma de graus dos nós é igual a duas vezes o número de arestas de G. Isto é, se o grau de qualquer nó é o número de arestas conectadas a ele (para o nó n1 com duas arestas conectadas a ele, grau = 2), a soma de todos os graus de um grafo será o dobro do tamanho de um grafo (o número de arestas). Em outras palavras, uma rede não é simplesmente feita de certo número de elementos conectados um ao outro, mas é constituído e qualificado pela conectividade dos nós. Quão conectado você é? Qual tipo de conexão você tem? Para um quadrado, a soma de graus é 8 (os nós [os cantos do quadrado] têm cada um duas arestas [as linhas do quadrado] conectados a eles), enquanto a soma das arestas é 4. Nas indústrias de TI, a conectividade é puramente uma medição quantitativa (largura da banda, número de conexões simultâneas, capacidade de download). Contudo, de um modo diferente, Deleuze e Guattari descrevem as formas de redes como um rizoma, sendo, de fato, arestas que contêm nós (e não vice-versa), ou mesmo arestas sem nós. Na teoria dos grafos, observamos que a conectividade de um grafo ou rede é um valor diferente de uma mera contagem do número de arestas. Um grafo não apenas tem arestas entre nós, mas arestas conectando nós.

De tal modo, a partir de uma perspectiva da teoria dos grafos, as redes oferecem três características básicas: a organização em nós e arestas (pontos e linhas), a conectividade e a topologia. Semelhante conjunto de princípios pode resultar em uma rede centralizada, rigidamente organizada, ou em uma rede distribuída, altamente flexível. O desenvolvimento institucional, econômico e técnico da Internet é um bom exemplo. Embora a implantação da tecnologia de comutação de pacotes na ARPANET (Advanced Research Projects Agency Network; Agências de Projetos de Pesquisa Avançada), do Departamento de Defesa dos EUA, tenha servido ostensivamente aos objetivos de pesquisa e segurança militar, tal rede de agências também se desenvolveu significativamente como uma rede comercial. Paul Baran, cocriador da comutação de pacotes, usa os princípios básicos da teoria dos grafos para mostrar que, dado igual conjunto de nós/pontos e diferente conjunto de arestas/linhas, pode-se obter três tipos muito diferentes de redes. Pontos iguais, linhas diferentes, redes diferentes. Semelhante distinção entre centralizado, decentralizado e distribuído pode ser encontrada em todo lugar hoje, não apenas em computadores e tecnologias da informação, mas também em redes sociais, políticas, econômicas e, especialmente, biológicas.

Da perspectiva da teoria dos grafos, podemos provisoriamente descrever as redes como conjuntos metaestáveis de relações variáveis e configurações com múltiplos nós e arestas. Como indicamos, as redes se apresentam de todas as formas e estilos, mas os tipos comuns de redes incluem as centralizadas (esquemas piramidais, hierárquicos), as descentralizadas (um hub principal ou “determinantes” com periferias radiadas) e as distribuídas (um conjunto de relações entre nós sem determinações ou centros). Em resumo, as redes podem ser dispostas para quase tudo: computadores (Internet), carros (estradas), pessoas (comunidade), animais (cadeia alimentar), ações (capital), declarações (instituições), cultura (diásporas), e assim por diante. De fato, muitas das pesquisas em sistemas dinâmicos complexos e ciência das redes ressaltam essa convergência de fenômenos heterodoxos a partir de princípios matemáticos universais[9].

Contudo, ressaltamos o seguinte ponto: a teoria dos grafos isoladamente não é suficiente para uma compreensão das redes; ou melhor, ela é apenas o início. Embora a teoria dos grafos forneça as bases matemática e técnica de variadas redes tecnológicas (e as ferramentas para a análise das redes), os pressupostos da teoria dos grafos são também instrutivas para o que omitem. Por exemplo, a divisão entre nós e arestas implica que enquanto os nós se referem a objetos, localizações ou espaços, a definição de arestas se refere a ações efetuadas por nós. Enquanto a agência é atribuída para ativar os nós, a efetivação das ações é atribuída às arestas passivas (o efeito de causalidade implícito nos nós). Grafos e redes são, pois, diagramas de relações de forças (arestas) efetivadas por agenciamentos discretos (nós). Assim, os grafos implicam uma orientação espacial privilegiada, abstrata quantitativa, e uma nítida divisão entre ator e ação. O paradoxo dos grafos ou das redes é que, na verdade, suas bases geométricas (ou viés) funcionam contra um entendimento das redes enquanto um conjunto de relações existentes no tempo.

A partir de nosso emprego da frase controle protocológico, sugerimos algo mais. As redes se distinguem não apenas por suas topologias gerais, mas também por sempre conter variadas topologias coexistentes, sendo às vezes incompatíveis. Uma topologia “técnica” da Internet poderia descrever isso como distribuída (por exemplo, no caso das redes de compartilhamento de arquivos ponto-a-ponto baseadas no modelo Gnutella). Contudo, tal topologia técnica é indissociável de sua causa, uso e regulação, tornando-a igualmente uma topologia social (comunidades de compartilhamento de arquivos), uma topologia econômica (distribuição de mercadorias) e ainda uma topologia legal (direitos autorais digitais). Todas essas redes coexistem e às vezes se conflitam, tal como a controvérsia em torno do compartilhamento de arquivos tem mostrado.

Protocolo em Redes de Computadores

Em um sentido técnico, as redes de computadores configuram nada mais que modelos esquemáticos descrevendo variados protocolos e as organizações dos dados desses protocolos. Tais protocolos são organizados em camadas. O white paper chamado “Requisitos para hosts da Internet” define quatro camadas básicas de linhas para um agrupamento de protocolos da Internet:

- A camada de aplicação (ex.: Telnet, a Web);

- A camada de transporte (ex.: TCP);

- A camada da Internet (ex.: IP);

- A camada de link (ou de acesso-mídia) (ex.: Ethernet).

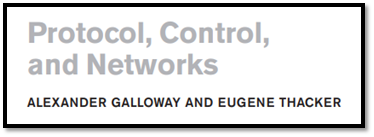

Tais camadas são alinhadas, significando que a camada de aplicação é alinhada com a camada de transporte, que está alinhada com a camada de Internet, e assim por diante. Para cada nível, o protocolo de maior precedência analisa e encapsula o protocolo de menor procedência. Análise e encapsulamento são ambos baseados em padrões: a análise (cálculos de verificação de somas, de medição de tamanhos, e assim por diante) compele os dados por meio de padrões, enquanto o encapsulamento adiciona um padrão específico de informação (um cabeçalho) ao início do objeto de dados.

Após o cabeçalho vem o restante do datagrama. Mas o que isto significa em termos práticos? Considere uma simples conversação telefônica como uma analogia. Há muitos protocolos em ação durante uma chamada telefônica. Alguns são técnicos, outros sociais. Por exemplo, o ato de ouvir o tom para discagem e discar o número desejado pode ser considerado uma “camada” diferente da conversa em si mesma. Além disso, as declarações formais que abrem e fecham a conversação – “Alô”, “Oi, aqui é…”, “Olha, falarei contigo mais tarde”, “Ok, até”, “Até breve” – não fazem parte da “camada” normal da conversação, mas apenas necessárias para estabelecer o início e o fim da conversação.

A Internet funciona da mesma maneira. A camada de aplicação é como a camada de conversação da chamada telefônica. Ela é responsável pelo conteúdo da tecnologia específica em questão, seja uma checagem de e-mail ou um acesso a site. A camada de aplicação é uma camada semântica, isto é, responsável pela preservação do conteúdo dos dados na transação em rede. A camada de aplicação não se preocupa com problemas maiores, tais como estabelecer a conexão em rede ou realmente enviar os dados entre as conexões. Ela apenas quer que a “conversação” funcione corretamente.

A camada de transporte está um passo acima da camada de aplicação, na hierarquia. Ela não se preocupa com o conteúdo da informação (e-mail ou site, por exemplo). Em vez disso, a camada de transporte é responsável por afiançar que os dados que trafegam pela rede cheguem corretamente ao seu destinatário. É uma camada social, isto é, situa-se entre o conteúdo ou o significado dos dados sendo transferidos e o ato automático de transferir os dados. Se os dados são perdidos no tráfego, a responsabilidade por reenviar os dados perdidos é da camada de transporte.

Assim, em nossa hipotética conversação telefônica, se alguém sente um corte na linha, pode interpor o comentário “Olá… Está ainda aí?” Tal comentário não faz parte da camada de conversação (a não ser que a conversação seja sobre “ainda estar aí”); é um comentário intersticial destinado a confirmar que a conversação está trafegando corretamente pela linha telefônica. Os comentários de abertura e fechamento também fazem parte da camada de transporte. Eles confirmam que a chamada foi estabelecida e que está pronta para a camada de conversação – e, inversamente, que a conversação foi finalizada e a chamada será concluída.

A terceira camada é a da Internet. Esta é ainda mais ampla que as de aplicação e transporte. A camada de Internet se preocupa com uma coisa: a movimentação real dos dados de um lugar para outro. Não tem interesse no conteúdo dos dados (responsabilidade da camada de transporte) ou se partes dos dados foram perdidos em trânsito (responsabilidade da camada de transporte).

A quarta camada, a camada de link, é a camada específica de hardware que, por fim, deve encapsular todas as transferências de dados. As camadas de link são altamente variáveis devido às muitas diferenças nos hardware e em outras mídias físicas. Por exemplo, uma conversação telefônica pode trafegar tão facilmente em um cabo telefônico normal quanto em um cabo de fibra-óptica. Porém, em cada caso a tecnologia em questão é radicalmente diferente. Tais protocolos tecnológicos específicos é a preocupação da camada de link (ou do acesso-mídia).

As diferentes responsabilidades das diferentes camadas de protocolos permitem que a Internet realmente funcione. Por exemplo, a divisão do trabalho entre a camada de transporte e a camada de Internet – pelas quais a correção de erros é a única responsabilidade da camada de transporte, e o roteamento (o processo pelos quais os dados são “roteados” e enviados para os seus destinos finais) é a única responsabilidade da camada de Internet – cria as condições de existência para a rede distribuída.

De tal modo, se um roteador cair em Chicago enquanto uma mensagem está em rota para Nova Iorque ou Chicago, os dados perdidos podem ser reenviados via Louisville (ou Toronto, Kansas City, Lansing ou uma miríade de outros nós). Não importa se o nó alternativo é mais curto ou largo, se está em uma diferente sub-rede, em outro país ou se utiliza um sistema operacional diferente.

O Requests for Comments (RFCs) destaca tal qualidade de flexibilidade com enorme eficácia:

Uma finalidade básica de construção da Internet é tolerar uma ampla gama de características de redes – exemplos: largura de banda, delay, perda de pacotes, reordenamento de pacote e tamanho máximo de pacote. Outro objetivo é a robustez contra as falhas de redes individuais, gateways e hosts individuais usando qualquer largura de banda ainda disponível. Por fim, o objetivo é o “sistema aberto interconexo”: um host de Internet precisa ser capaz de interoperar de forma robusta e efetiva com os outros hosts de Internet, por todos os seus diversos caminhos.[10]

Desde que os hosts na rede estejam conformes ao conjunto geral de protocolos da Internet – com uma língua franca para computadores –, as camadas de transporte e Internet, trabalhando em conjunto, cuidarão de tudo.

O objetivo final dos protocolos de Internet é a totalidade. As virtudes dos protocolos de Internet são a robustez, a contingência, a interoperabilidade, a flexibilidade, a heterogeneidade e o panteísmo. Aceita-se tudo, não importando a origem, o remetente ou destinatário.

Figura 2: Um cabeçalho de “Internet Protocol” (IP). Fonte: “Internet Protocol DARPA Internet Program Protocol Specification,” RFC 791, September 1981.

Protocolo em Redes Biológicas

No exemplo das redes de computadores, o “protocolo” é um termo técnico e, como sugerimos, um modo de descrever o controle particular para as redes informáticas em geral. O que é o “protocolo” para as redes biológicas? Embora a biologia molecular, a genética e os campos da biotecnologia não usem o termo técnico protocolo, eles empregam protocolos em diversos níveis. Lembre-se que o conceito de protocolo desenvolvido aqui combina uma visão genérica com uma descrição de relações padronizadas de redes. Enquanto a biotecnologia é uma indústria supreendentemente diversificada, ela também se baseia em um arranjo comum de conhecimentos, que incluem biologia celular, bioquímica e genética molecular. Talvez nenhum outro conceito seja tão central para as biotecnologias quanto a noção de “informação” genética. Tal como historiadores da ciência têm afirmado, a ideia de uma visão informática de corpos genético e molecular tem sua raiz nas trocas interdisciplinares entre a cibernética e a biologia durante o período do pós-guerra.[11] No próprio conceito do Projeto Genoma Humano [Human Genome Project], dos produtos farmacêuticos genéticos, das patentes genéticas e do bioterrorismo, há a noção de um “código” genético que é central para a compreensão da “vida” no nível molecular.

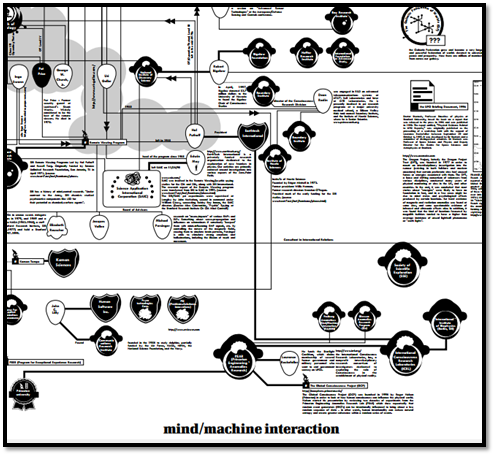

Podemos sugerir que os protocolos de redes biológicas são modos de regulação e controle biológicos no genoma e na célula. Esses protocolos são de três tipos: expressão gênica (como uma rede de genes é ativada e desativada para produzir proteínas), metabolismo celular (como os componentes de enzimas e organelas transformam “alimento” em energia) e sinalização de membrana (o mecanismo de criptografia molecular que leva moléculas para dentro e fora da membrana). Em cada uma das interações moleculares (complementaridade do DNA, catálise enzimática, ligação molecular) são envolvidas para construir relações em rede, tal como a transcrição do DNA em RNA, a conversão de moléculas de açúcar em energia utilizável ou a infecção por um agente viral ou bacteriano. Em cada tipo de protocolo, vemos redes de componentes biológicos interagindo com outras, dirigidas por um “código genético” e mediadas por “informação bioquímica”.

Indubitavelmente, a instrumentalidade dos processos biológicos tem sido uma marca da biotecnologia ao longo da história. Testemunhamos com frequência redes biológicas em ação, como os exemplos recentes dos atos de terroristas com antraz, a epidemia da síndrome respiratória aguda grave (SRAG) e a legislação acerca das leis mundiais de propriedade intelectual. Contudo, somente quando vemos a biotecnologia em seu contexto não médico, ainda instrumental, que os protocolos das redes biológicas se tornam mais evidentes. Um exemplo é o nascente campo da computação de DNA ou a “biocomputação”.[12] Embora a computação de DNA seja tão nova ao ponto que ainda não encontrou seu “killer app”, ela tem sido utilizada em diferentes contextos – desde uso em segurança e criptografia, passando para roteamento de rede ou de problemas de navegação até uso em detecção portátil de agentes de guerra biológica. A computação de DNA é exemplo da ampla mudança nas ciências genéticas, em direção ao paradigma das redes.

As técnicas de computação de DNA foram desenvolvidas em meados da década de 1990 por Leonard Adleman como um experimento de prova de conceito em ciência da computação[13]. O conceito explica que as possibilidades combinatórias inerentes ao DNA (não um, mas dois conjuntos de pareamentos binários em paralelo: A-T, C-G) podem ser usadas para resolver tipos específicos de cálculos. Um exemplo famoso é o chamado problema do caixeiro-viajante (também chamado mais formalmente de problemas de “caminho hamiltoniano rastreável”): você é um caixeiro-viajante e precisa ir para cinco cidades. Você pode visitar cada uma somente uma vez, sem refazer qualquer caminho. Qual é o caminho mais eficiente para visitar as cinco cidades? Em termos matemáticos esses tipos de cálculos são chamados de problemas de “NP-Completos” ou problemas de “poligonais não lineares”, porque eles envolvem um vasto campo de pesquisa que aumenta exponencialmente à medida que o número de variáveis aumenta (cinco cidades com cinco caminhos possíveis). Para os computadores baseados em silício, calcular todas as possibilidades de tais problemas pode ser computacionalmente desgastante. Contudo, para uma molécula como o DNA, o princípio mais estudado de “complementaridade de bases” (A sempre ligado a T e C sempre ligado a G) perfaz algo parecido a um processamento de computador, exceto que ele não funciona por meio de circuitos microelétricos, mas através do recozimento enzimático de cadeias simples de DNA. Você pode “marcar” um segmento de qualquer cadeia simples de DNA em cada localidade (utilizando marcadores genéticos ou corante fluorescente), realizar cópias suficientes para cobrir todas as possibilidades (utilizando um termociclador de reação em cadeia de polimerase, um tipo de máquina de Xerox para DNA), e então misturar. O DNA misturará e combinará todas as localidades em variadas sequências lineares e, muito possivelmente, uma dessas sequências representará a mais eficiente solução para o seu problema do “caixeiro viajante”.

Enquanto um modo de controle de protocolo, a biocomputação codifica a rede no corpo biomolecular. Os nós da rede são os fragmentos de DNA (codificados em nós específicos, A, B, C, D etc.) e as arestas são os processos de ligação de pares de bases entre fragmentos complementares de DNA (codificados em sobreposições A-B, B-C, C-D etc.). A rede resultante do experimento é, na verdade, um conjunto de rede; o computador de DNA cria uma variedade enorme de redes, cada rede fornecendo um caminho hamiltoniano. A rede é, pois, uma série de filamentos de DNA, sendo ela combinatória e recombinatória. Tal codificação implica uma correlata zona de recodificação e decodificação conforme a rede move de um substrato material (pixels, papel e tinta) para outro substrato qualitativamente diferente (DNA, GPCRs, ciclo de Krebs). A perspectiva da computação celular é a mais interessante a esse respeito, uma vez que abarca uma disciplina já trabalhando com uma lógica diagramática (bioquímica e o estudo do metabolismo celular) e codifica uma rede em uma rede (caminhos hamiltonianos em ciclos de Krebs).

A biocomputação – e o exemplo da computação de DNA, em particular – demonstra um controle protocológico no micronível das biomoléculas, das ligações moleculares e dos processos de recozimento/desnaturação. A computação de DNA mostra como o processo de resolução de problemas não depende de qualquer “agente” de resolução de problemas, todavia que a solução (matemática e biologicamente) venha de um contexto de regulação distribuída. A solução não surge a partir do processamento de um número bruto, mas a partir de um aberto e flexível arranjo de possibilidades totais. O protocológico é isso. O campo de busca exponencial para os problemas de NP-Completo fornece ao DNA um contexto no qual a complementariedade de pares procede de um modelo altamente distribuído. Isso significa que a computação de DNA facilita um conjunto de relacionamento ponto-a-ponto entre os seus nós de pares de bases, que se ligam ou não. A partir de tal perspectiva, a computação de DNA realiza suas computações sem um controle direto e centralizado. Tudo o que é a computação de DNA precisa é de contexto e um conjunto de problemas definindo um campo de pesquisa (tal como o caminho hamiltoniano). Lembre-se que uma das primeiras preocupações da ARPANET foi o desenvolvimento de uma rede na qual seria suficientemente robusta para sobreviver às falhas de um ou mais nós. O problema do caminho hamiltoniano de Adleman poderia ser facilmente reconstituído como um problema contingencial: dado um caminho direcionado via um dado conjunto de nós, quais são as alternativas possíveis caso um dos nós seja subtraído desse conjunto?

Contudo, tal caráter distribuído de modo algum implica uma liberdade de controle. Em vez disso, no contexto do protocolo, a computação de DNA estabelece os termos pelos quais a atividade da rede (computação de problemas matemáticos com extensas áreas de pesquisa) pode possivelmente ocorrer. De um modo específico, a computação de DNA é “biológica”, uma vez que apenas certo número de processos biológicos é isolado para realizar esse problema. Os protocolos biológicos e os princípios de biologia molecular (expressão genética, metabolismo e sinalização) formam o fundamento para redes biológicas mais conhecidas, de doenças infecciosas, de doadores e transplantes de órgãos, de sistemas de patentes biológicas e das táticas epidemiológicas de guerra biológica e bioterrorismo[14].

Figura 3: Topologias de redes em metabolismo celular. Publicado originalmente em: Benno Schwikowski, et al., “A Network of Protein-Protein Interactions in Yeast”, Nature Biotechnology (Dec. 2000).

Uma Vida Codificada

Temos, pois, duas redes – uma rede de computadores e uma rede biológica – ambas altamente distribuídas, robustas, flexíveis e dinâmicas. Embora a primeira seja baseada em silício e use conceitos biológicos (agentes inteligentes, vida artificial, algoritmos genéticos), a segunda é totalmente biológica e ainda assim se recodifica em termos computacionais (biologia como computação, em oposição à evolução). Dois “computadores”, duas redes – dois protocolos? Sim e não. O que podemos aprender a partir da compreensão da computação de DNA é que o controle biológico pode ser tanto biológico como computacional. No exemplo da computação de DNA, o que é protocolo? Por um lado, o escopo do experimento é matemático e computacional; por outro lado, o meio pelo qual isso é realizado é biológico e bioquímico. De tal modo, embora os protocolos computacionais possam governar o funcionamento interno dos componentes informáticos da computação de DNA, os protocolos também governam a interface entre o úmido e o seco, o informático e o biológico. Portanto, duas ordens ocorrem simultaneamente. No exemplo do TCP/IP, o controle protocológico é quase exclusivamente matemático e computacional, com o wetware estando fora da máquina. O protocolo facilita a integração e padronização desses dois tipos de redes: uma rede “inter”, relacionando diferentes ordens materiais (silício-carbono), e uma rede “intra”, relacionando diferentes variáveis por meio de funcionamento protocológico (nós como DNA; arestas como pares de bases relacionadas). Assim, o protocolo da biocomputação duplica o trabalho. É literalmente biotécnico, integrando a lógica e os componentes específicos dos computadores e a lógica e os componentes específicos da biologia molecular.

Enfatizemos novamente um ponto destacado no início: protocolo é emanação material de controle distribuído. O protocolo não é um exercício de poder “de cima”, apesar da flagrante organização hierárquica do Domain Name System [Sistema de Nomes de Domínio] ou das políticas incertas a respeito de patentes genéticas do gabinete de marcas e patentes dos Estados Unidos. O protocolo também não é uma liberação anárquica de dados “de baixo”, apesar da organização distribuída de TCP/IP ou das possibilidades combinatórias de expressão genética. A relação entre protocolo e poder é de certa maneira invertida: quanto maior a natureza distribuída da rede, maior o número de controles que permite que a rede funcione como uma rede. O protocolo responde à questão complicada sobre como o controle permeia as redes distribuídas. Em outras palavras, o protocolo nos diz que as relações de poder heterogêneas e assimétricas são a essência absoluta da rede-Internet ou da rede-genoma, não seus grilhões.

Tanto nas redes de computadores como nas biológicas, a função primária do protocolo é dirigir o fluxo de informação. De certo modo, isso não é surpresa, pois ambos os campos têm raízes comuns na Segunda Guerra Mundial e nas pesquisas tecnológicas do pós-guerra.[15] O que as genealogias da cibernética, da teoria da informação e as teorias de sistema mostram, no entanto, é que “informação” e o mundo da informação expõem uma relação ambivalente no mundo material. Por um lado, a informação é vista como sendo abstrata, quantitativa, redutível a um cálculo de gestão e regulação – sendo isso a noção incorpórea e imaterial de “informação” mencionada acima. Por outro lado, cibernética, teoria da informação e teoria dos sistemas exibem como a informação é imanentemente imaterial, configurada em tecnologia militar, canais de comunicação e até mesmo em sistemas biológicos. No loop de realimentação cibernético, nos canais de comunicação e na totalidade orgânica de qualquer sistema, encontramos tal visão dúplice da informação. Ao mesmo tempo imaterial e material, abstrata e concreta, um ato e uma coisa.

Em resumo, podemos dizer que as sociedades de controle de Deleuze fornecem um medium por meio do qual o protocolo é capaz de se expressar. Neste caso, é a “informação” – em todos os sentidos contraditos do termo – que constitui a capacidade do protocolo de materializar redes de todos os tipos. O protocolo sempre implica alguma forma de ação através da informação. De certo modo, a informação é o conceito que permite uma variedade enorme de redes – computacional, biológica, econômica, política – tornar-se redes. A informação é a mercadoria-chave na lógica de organização do controle protocológico. A informação é a substância do protocolo. A informação dá sentido ao protocolo.

Em Direção a uma Ontologia das Redes

Embora a teoria dos grafos e a ciência das redes nos forneçam um conjunto de princípios úteis para analisar as redes, elas também tendem a ofuscar algumas das suas principais características: a temporalidade dinâmica (redes “virtuais” bergonsianas), a importância das arestas e dos nós (as arestas-sem-nós de Deleuze e Guattari) e a possibilidade de ter mais de uma topologia para cada rede (as “coletividades singulares” de Negri).

Idealmente, nossa ontologia política das redes forneceria um conjunto de conceitos para descrever, analisar e criticar o fenômeno da rede. Dependeria e até exigiria um conhecimento técnico de certa rede, contudo sem ser determinado por ela. Captaria as relações fundamentais de controle em uma rede enquanto imanente e integrada ao seu funcionamento. Mais significantemente ainda, tal ontologia política levaria em conta a natureza bilateral das redes na sociedade de controle, ao mesmo tempo em que cria novas aberturas.

Um primeiro princípio, pois, é o conceito de individuação. Para Deleuze, um modo de individuação tem pouco a ver com sujeitos humanos individuais e mais a ver com o processo por meio do qual os agregados são mantidos ao longo do tempo. Como ele afirma, a “linguagem digital de controle é feita de códigos indicando onde o acesso a certa informação deve ser aceito ou negado”. “Não estamos mais lidando com a dualidade de massa e individual” da era moderna. Em vez disso, “os indivíduos tornam-se ‘dividuais’ e as massas tornam-se amostras, dados, mercados ou ‘bancos’” [16]. Do mesmo modo, Gilbert Simondon, escrevendo sobre a relação entre individuação e formas sociais, sugere que devamos “compreender o indivíduo pela perspectiva do processo de individuação e não pelo processo de individuação por meio do indivíduo” [17]. Assim, uma rede também individua a si mesma de uma maneira construtivista; pois, embora o todo seja maior do que a soma das partes, são, contudo, as partes (ou as ações localizadas de um agrupamento), que constituem a possibilidade de individuação de “uma” rede. Não obstante, o modo como uma individuação primária ocorre pode ser completamente diferente do modo como uma secundária ocorre; a individuação da rede como um todo não é a individuação dos componentes da rede. Ademais, a individuação está relacionada à identificação – identificar as redes, identificar as agências de rede. Em resumo, a distinção política entre o indivíduo e o grupo é transformada em uma regulação protocológica entre a rede como uma unidade e a rede como uma heterogeneidade (o que os programadores de computador denominam “struct”, uma matriz com tipos díspares de dados). Em termos de controle protocológico, a questão da individuação é a de como são identificados e gerenciados os nós discretos (agências) e as arestas (ações) enquanto nós e arestas. O que define um nós e uma aresta em determinada rede? Isso muda conforme a granularidade da análise? O que resiste às individuações ou às “dividuações”? O que sustenta as individuações ou as diversificam?

A partir do acima segue o segundo princípio: as redes são uma multiplicidade. Elas são robustas e flexíveis. Ainda que as redes possam ser bem facilmente individualizadas e identificadas, elas também são sempre “mais de uma”. Redes são multiplicidades, não porque são construídas de inúmeras partes, mas porque são organizadas. Isso significa não somente que as redes podem crescer (adicionando nós e arestas), mas, mais significantemente, que as redes são reconfiguráveis – talvez seja esse o sentido de rede, ser capaz de transformação, reconfiguração. Como Deleuze e Guattari notaram, “o múltiplo precisa ser feito, não sempre adicionando uma dimensão maior, mas sim da maneira mais simples, pela força da sobriedade, no nível das dimensões de que se dispõe – sempre n-1” [18]. Em dinâmicas de redes descentralizadas e, especialmente, em redes distribuídas, a topologia da rede é criada pela subtração de nós centralizadores e/ou arestas distribuídas versus aglomeração. Um sinônimo técnico para multiplicidade é, portanto, tratamento de contingência, ou como uma rede é capaz de gerenciar mudanças repentinas, não planejadas ou localizadas em si mesmas (incorporada na própria ideia de Internet). Como Negri afirma, “a multitude é um agente social ativo, uma multiplicidade que age. Ao contrário do povo, a multidão não é uma unidade, mas, opondo-se às massas e plebes, podemos vê-la de maneira organizada. De fato, é um agente de auto-organização”[19]. Uma rede é, de certo modo, algo que mantém uma tensão em si mesma – um agrupamento unificado de diferenças. É menos a natureza das partes em si mesmas que importa, e mais a relevância das condições sobre as quais tais partes podem interagir. Quais são os termos, as condições, sobre as quais “uma” rede pode ser constituída por múltiplas agências? Protocolos servem para fornecer essas condições de possibilidade, e o controle protocológico, os meios que facilitam tais condições.

Uma terceira conclusão, a do movimento, serve para relevar as qualidades inerentemente dinâmicas das redes. Embora tenhamos afirmado que as redes são uma e múltiplas, tal afirmação serve apenas para retratação estática e momentânea de uma rede. A maioria das redes que conhecemos – econômica, epidemiológica, computacional – é dinâmica. Havendo talvez um truísmo no estudo das redes, elas seriam redes somente quando estão “vivas”, quando estão instituídas, incorporadas ou tornadas operacionais. Isso se aplica tanto às redes em sua potencialidade (células adormecidas, redes inativas, telefones celulares ociosos) quanto às redes em atividade. No sentido cotidiano, isso é óbvio – movimentos de troca, distribuição, acumulação, desagregação, enxame, aglomeração são a própria “coisa” de uma variedade de ambientes, de cidades concentradas a economias transnacionais, de contágios interculturais a tecnologias móveis, sem fio. Contudo, nossa imprescindível necessidade de localizar, posicionar e, literalmente, identificar os nós das redes às vezes ofusca a qualidade dinâmica das arestas. Parafraseando Henri Bergson, nós frequentemente tendemos a compreender a qualidade dinâmica das redes em termos de estática; compreendemos o tempo (ou a duração) em termos de espaço. Ele escreve, “há mudanças, mas por trás das mudanças não há coisas que mudem: a mudança não precisa de um suporte. Há movimentos, mas não há objetos inertes ou invariáveis que se movam: o movimento não implica um móvel”.[20]

Finalmente, hoje a perspectiva peculiar da informática sobre as redes trouxe consigo uma série de preocupações diferentes de outras redes não baseadas em TI, como as de transporte e de comunicações analógicas. O popular discurso do ciberespaço como fronteira global ou bem comum digital, onde o acesso é uma mercadoria, transmite a mensagem na qual a economia política das redes é gerenciada através da conectividade. Como comentaram os pesquisadores John Arquilla e David Ronfeldt, da RAND, enquanto um modelo mais antigo de dissidência objetivava “derrubar o sistema”, hoje variados movimentos políticos atuais baseados em redes estão mais interessados em “conectarem-se” – e permanecerem assim.[21]

Certamente existem muitas outras maneiras de compreensão de redes similares às que mencionamos. Nosso objetivo não é simplesmente substituir a atual perspectiva centrada na ciência por outra mais política ou filosófica. Em vez disso, queremos propor uma compreensão dos mecanismos de controle a partir das redes precisam ser pluridimensionais tal como são as próprias redes. Uma forma de preencher a lacuna entre os modos técnicos e políticos das redes é, pois, pensar as redes como continuamente expressando seus próprios modos de individuação, multiplicidade, movimento e níveis de conectividade – do menor aos mais altos níveis de redes. É por essa razão que vemos as redes como ontologias políticas inseparáveis de suas práticas e, da mesma maneira, tentamos fundamentar este ensaio em uma análise da prática material das redes tal como ela existe nas ciências biológicas e ciências informáticas.

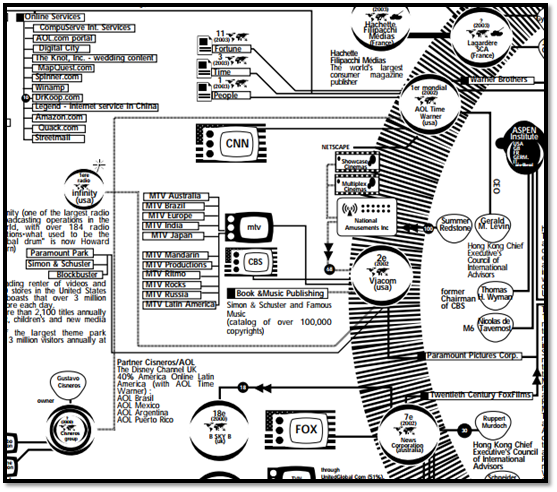

Figura 4: Bureau d’Etudes. Infowar/Psychic War, 2003. Detalhe. Disponível em: https://bureaudetudes.org/wp-content/uploads/2010/01/Worldmedia2003.pdf

Contraprotocolo

Contemplando tudo a partir do conflito entre rede-rede, podemos realizar mais um questionamento: como as redes transformam o conceito de resistência política? Tal como salientamos, o caráter distribuído das redes de modo algum implica a ausência de controle ou a ausência de dinâmica política. A natureza protocológica das redes é tanto sobre a manutenção do status quo quanto sobre a perturbação da rede.

Podemos começar a abordar a questão reconsiderando a resistência no contexto das tecnologias em rede. Se as redes não são apenas sistemas técnicos, mas também “redes vivas”, em tempo real, dinâmicas e experienciais, então faria sentido considerar do mesmo modo a resistência como vida-resistência. Isso é o que Hardt e Negri chamam de “ser-contra”; isto é, o vasto potencial de vida humana combatendo as forças de exploração. [22] Há (pelo menos) dois sentidos para o termo vida-resistência: (1) vida é o resiste ao poder; e (2) à medida que é cooptada pelo poder, a “vida em si mesma” precisa ser combatida pelos sistemas vivos.

Deleuze assevera, “A vida se torna resistência ao poder quando o poder toma a vida como seu objeto”. [23] Por um lado, a vida é um tipo de contrapoder, um fluxo de retorno de forças voltadas para trás em direção à origem da exploração, resistindo seletivamente às formas de homogeneização, canalização e subjetivação. (Mas isso não é, pois, realmente uma resistência, mas sim uma intensificação, uma lubrificação da vida).

Quando o poder se torna biopoder, a resistência se torna poder de vida, um poder-vital que não pode ser confinado em espécies, lugares ou caminhos deste ou daquele diagrama… A vida não é essa capacidade de resistir à força? … Não há como definir o que o homem pode alcançar “enquanto um ser vivo”, enquanto um conjunto de “forças que resiste”. [24]

Por outro lado, a vida é igualmente aquilo a que se resiste (resistência-à-vida), aquilo contra qual impulsiona a resistência. Hoje a “vida em si mesma” é encaixotada por concorrentes definições biológicas e computacionais. Na definição biológica, o ícone do DNA é pensado como explicação de tudo, do Alzheimer ao Transtorno do Déficit de Atenção. Na definição computacional, a vigilância informática e o extenso banco de dados do social promovem uma noção de atividade social que pode ser traçada por meio de registros de transações, rastros e comunicações. Resistência-à-vida é, pois, um desafio posto a qualquer situação na qual a definição normativa da “vida em si mesma” se encaixa em um uso instrumental dessa definição.

Essa consideração de vida-resistência torna possível um “contraprotocolo”? Se sim, como as práticas contraprotocológicas podem evitar cair nas conhecidas aporias de oposição e recuperação? Podemos encerrar com algumas sugestões.

Primeiro, as práticas oposicionais terão que se concentrar não em um mapa estático de relacionamentos um-para-um, mas em um diagrama dinâmico de relacionamentos muitos-para-muitos. Isso significa que os contraprotocolos das atuais redes serão maleáveis e vigorosos nos lugares em que os protocolos são flexíveis e robustos. [25] A prática protocológica não evitará o tempo de inatividade. Ela será reiniciada com frequência.

Segundo, em relação às táticas. Na verdade, a prática contraprotocológica não é “contra” nada. Assim, o conceito de resistência na política deveria ser superado pelo conceito de hipertrofia. O objetivo não é destruir a tecnologia por alguma ilusão neoludista, mas levar a tecnologia a um estado hipertrófico, mais longe de que se supunha ir. Devemos sobrelevar, e não desconectar.

Terceiro, porque as redes são (tecnicamente) baseadas na criação de possíveis comunicações entre nós, as práticas oposicionais terão de focar menos nas características dos nós e mais na qualidade das arestas-sem-nós. Em tal sentido, a distinção nó-aresta será quebrada. Nos meios de comunicação, as transmissões são fundamentais. Os nós podem ser compostos de agregação de arestas, enquanto as arestas podem ser nós estendidos.

Utilizando vários protocolos como padrões operacionais, as redes tendem a combinar uma extensa massa de diferentes elementos sob um único guarda-chuva. Práticas de contraprotocolo podem capitalizar a homogeneidade encontrada nas redes ressoando por toda parte com pouco esforço. O controle protocológico funciona por meio de tensões e, de tal modo, as práticas de contraprotocolo podem ser compreendidas como um tipo particular de implementações e intensificações de controle protocológico.

O controle protocológico promove a criação e regulação da vida em si mesma. Em outras palavras, o conjunto de procedimentos para monitorar, regular e modular as redes como vivas é voltado, no nível mais fundamental, à produção da vida, em suas capacidades biológicas, sociais e políticas. Assim, o objetivo não é somente o protocolo; em lugar disso, de modo mais preciso, o objetivo da resistência é a forma na qual o protocolo inflecte e esculpe a vida em si mesma.

[1] John Arquilla; David Ronfeldt, Networks and Netwars: The Future of Terror, Crime, and Militancy (Santa Monica: RAND, 2001), 15; ênfases removidas.

[2] Há variadas posições no debate. As perspectivas tecnofílicas, tal como as expressas por Howard Rheingold e Kevin Kelly, são tanto manifestações de determinismo tecnológico quanto uma visão da tecnologia enquanto ferramenta de elevação do humanismo burguês, genericamente. A perspectiva jurídica/governamental, encontrada nas obras de Lawrence Lessig, Yochai Benkler e outros, postula um quadro similar, no qual as redes encontrarão uma realidade social mais justa e livre a partir de salvaguardas legais. A perspectiva da ciência das redes, expressa no popular livro de Mark Buchanan e Albert-László Barabási, retrata as redes como um tipo de lei natural apolítica, operando universalmente por sistemas heterogêneos, sejam eles de terrorismo, AIDS ou Internet; ainda, tal dicotomia (redes enquanto políticas e redes enquanto técnicas) é igualmente evidente em uma variedade de outras mídias, incluso agências de notícias, pesquisas de defesa e militares e indústrias de TI.

[3] Ver o recente ensaio de Mark Wigley com o mesmo título, na Grey Room 4 (Summer 2001), p. 80-122.

[4] A maior e mais importante série de publicações para os protocolos da Internet é denominada “Request for Comments” (RFC). Alguns milhares de documentos foram elaborados até o momento, sendo pesquisados, publicados e mantidos pela Internet Engineering Task e por organizações relacionadas.

[5] Hall, Eric. Internet Core Protocols: The Definitive Guide. Sebastopol: O’Reilly, 2000, 6, 407. Ver também o principal texto sobre protocolos de computadores: Stevens, W. Richard. TCP/IP Illustrated, Volume 1: The Protocols. New York: Addison-Wesley, 1994.

[6] Deleuze, Gilles. Negotiations. New York: Columbia University Press, 1995, p. 178.

[7] Deleuze, Gilles. Having an Idea in Cinema. In: Kaufman, Eleanor; Heller, Kevin Jon. Deleuze and Guattari: New Mappings in Politics, Philosophy and Culture. Minneapolis: University of Minnesota Press, 1998, p. 8; tradução modificada.

[8] Visões gerais sobre a teoria dos grafos estão presentes em qualquer livro didático de matemática discreta. Ver também: Chartrand, Gary. Introductory Graph Theory. New York: Dover, 1977. Os princípios da teoria dos grafos são comumente empregados em problemas de roteamento de redes e comunicações, bem como em planejamento urbano (sistemas de rodovias e metrôs), engenharia industrial (fluxo de trabalho em uma fábrica), biologia molecular (proteômica) e em mecanismos de busca na Internet.

[9] “Assim emerge uma teia de relacionamentos – um grafo –, um amontoado de nós conectados por links. Computadores ligados por linhas de telefone, moléculas de nosso corpo ligadas por reações bioquímicas, empresas e consumidores ligados por comércio, células nervosas conectadas por axônios, ilhas conectadas por pontes são exemplos de grafos. Seja qual for a identidade e a natureza dos nós e links, para o matemático eles foram os mesmos animais: um grafo e a rede”. Barabási, Albert-Lázló. Linked: The New Science of Networks. Cambridge, MA: Perseus, 2002, p. 16.

[10] Braden, Robert. “Requirement for Internet Host”, RFC 1123, October 1989.

[11] Ver: Kay, Lily. Who Wrote the Book of Life? A History of Genetic Code. Stanford: Standord University Press, 2000; e Keller, Evelyn Fox. Refiguring Life: Metaphors of Twentieth-Century Biology. New York: Columbia University Press, 1995.

[12] Ver: Dove, Alan. “From Bits to Bases: Computing with DNA”, Nature Biotechnology 16 (September 1998): 830-832; e Regalado, Antonio. “DNA Computing”, MIT Technology Review (May/June 2000). A biocomputação inclui subáreas como computação de proteína (utilizando reações enzimáticas), computação de membrana (utilizando receptores membranosos) e computação quântica (utilizando flutuações quânticas).

[13] Ver: Adleman, Leonard. “Molecular Computation of Solutions to Combinatorial Problems”. Science 266 (11 November 1994): 1021-1024. Ver também o artigo posterior de Adleman: “On Constructing a Molecular Computer”, First DIMACS Worshop on DNA Based Computers, Vol. 27 (Princeton: DIMACS, 1997), p. 1-21.

[14] Devemos também notar que o que diferencia a biocomputação de muitas pesquisas biotecnológicas é que ela é amplamente não médica em sua aplicação. Até agora, experimentos biocomputacionais têm sido aplicados em problemas de roteamento, segurança e criptografia. Ou seja, em vez de utilizar a tecnologia para aumento do domínio biológico, a biocomputação usa a biologia para o aumento do domínio tecnológico. Ao fazer isso, reconfigura a biologia a partir de uma linha de tecnologia; contudo, uma tecnologia que é totalmente biológica.

[15] Compare, por exemplo, as perspectivas das cibernética, teoria da informação e teorias dos sistemas. Primeiro, a perspectiva da cibernética de Nobert Wiener: “Sempre esteve muito claro para mim que a máquina de computação ultrarrápida iria, em princípio, de um ideal sistema nervoso central a um aparato de controle automático”. Wiener, Nobert. Cybernetics, or Control and Communication in the Animal and the Machine (Cambridge: MIT Press, 1965), p. 27. Segundo, a perspectiva da teoria da informação de Claude Shannon: “informação não pode ser confundida com significado. Em realidade, duas mensagens, uma carregada de significado e outra completamente nonsense, podem ser exatamente equivalentes, pela perspectiva atual, enquanto informação”. Shannon, C.; Weaver, W. A Mathematical Theory of Communication (Chicago: University of Illinois, 1963), p. 8. Finalmente, as teorias dos sistemas inspiradas biologicamente por Ludwig von Bertalanffy: “O organismo não é um sistema estático fechado ao exterior e sempre contém idênticos componentes; é um sistema aberto em estado quase estacionário, mantendo constante mudanças contínuas em sua massa relações de componentes materiais e energias, de modo que os materiais entram e saem continuamente para o ambiente exterior”, Bertalanffy, Ludwig von. General Systems Theory: Foundations, Development, Application (New York: George Braziller, 1976), p. 121. A perspectiva do controle de Bertalanffy argumenta de maneira contrastante à de Wiener ou de Shannon. Embora Bertalanffy possua uma definição de “informação”, essa desempenha um papel muito menor que outros fatores na regulação do sistema. A informação é central para qualquer sistema, contudo não é nada sem uma lógica geral na definição e uso da informação como recurso de gerenciamento de sistemas. Em outras palavras, as lógicas de tratamento da informação são tão importantes quanto a ideia de informação em si mesma.

[16] Deleuze, Negotiations, p. 180. Ênfase adicionada.

[17] Simondon, Gilbert, “The Genesis of the Individual”. In: Crary, Jonathan; Sanford, Kwinter. Zone 6: Incorporations. New York: Zone, 1992, p. 300. Ênfases do original removidas.

[18] Deleuze, Gilles; Guattari, Félix. A Thousand Plateaus. Trad. Brian Massumi. Minneapolis: University of Minnesota Press, 1987, p. 6.

[19] Negri, Antonio, “Approximations”, Interactivist Info Exchange. Posted 12 November 2002: http://slash.autonomedia.org.

[20] Bergson, Henri. The Creative Mind. Trad. Mabelle Andison. New York: Citadel Press, 1997, p. 147. Outra forma sustentar isso é propor que as redes não têm nós. Brian Massumi corrobora quando afirma que “em movimento, um corpo está em relação imediata e desdobrada com seu próprio potencial oculto de variação… Uma coisa é quanto não está se tornando”. Massumi, Brian. Parables for the Virtual. Durham: Duke University Press, 2002, p. 4-6.

[21] Arquilla, John; Ronfeldt, David, “The Advent of Netwar”. In: Arquila; Ronfeldt. Networks and Netwars, p. 5.

[22] Ver: Hardt, Michael; Negri, Antonio. Empire. Cambridge: Harvard University Press, 2000, p. 210.

[23] Deleuze, Gilles. Foucault. Trad. Seán Hand. Minneapolis: University of Minnesota Press, 1999, p. 92.

[24] Deleuze, Foucault, p. 92, tradução modificada. A citação se refere à História da Sexualidade de Foucault.

[25] “Estamos cansados de ser flexíveis. Ser flexível significa outra coisa, algo como vital e positivo. Talvez supermaleável [superpliant] seja o termo ideal, seguindo o emprego de Deleuze da palavra em seu apêndice para o livro sobre Foucault: “a Superdobra [Surpli], conforme atesta as próprias dobras das cadeias do código genético e o potencial do silício em máquinas de terceira geração… As forças no homem entram em relação com forças de fora, as do silício, que se vinga do carbono, as dos componentes genéticos, que se vingam do organismo, as dos agramaticais, que se vingam do significante. Em todos esses aspectos, seria preciso estudar as operações de superdobra, da qual a ‘dupla hélice’ é o exemplo mais conhecido”. Ver: Deleuze, Foucault, p. 131-132.